Presentar un nuevo método de optimización de modelos puede ser un desafío, pero el objetivo de este artículo es inequívoco: demostrar una técnica de pruning diseñada no para hacer los modelos más pequeños, sino para hacerlos más justos. Porque si un LLM va a ayudarte a tomar decisiones, sobre seguridad, contrataciones o diagnósticos, no puedes LEER MÁS

Categoría: grandes modelos de lenguaje

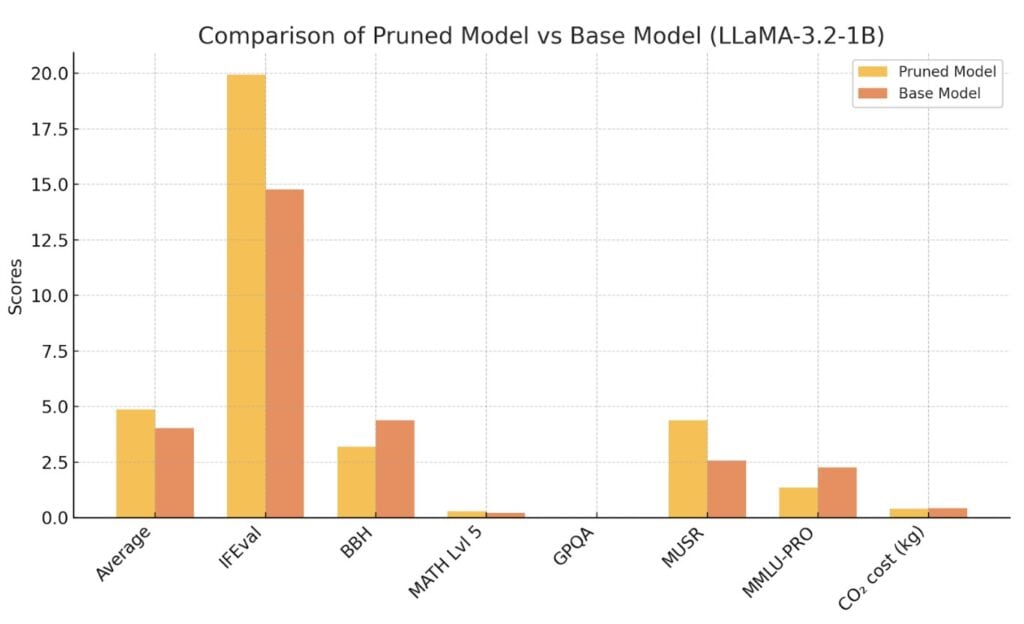

Creando small models eficientes con Llama 3.2 y Pruning.

Una de las técnicas primordiales, en la creación de Small Language Models es el Pruning, pero para ejecutar un proceso de pruning exitoso es imprescindible conocer la estructura de los modelos objetivo. En este artículo se explica como realizar un pruning sobre las capas MLP con estructura GLU (Gated Linear Units), es decir gran parte LEER MÁS

Montamos un sistema NL2SQL con Azure OpenAI Studio.

En el artículo anterior, aprendimos a montar un prompt que era capaz de generar órdenes SQL desde peticiones realizadas en lenguaje natural por parte del Usuario. Ahora veremos como utilizar Azure OpenAI Studio para crear un punto de inferencia al que podamos llamar y crear las órdenes SQL. Aunque posiblemente si estáis leyendo estas líneas LEER MÁS

Crear un SuperPrompt de conversión de Lenguaje Natural a SQL para OpenAI.

Una de las cosas que más ha cambiado en estos últimos meses, desde el Boom de ChatGPT, ha sido la aparición de modelos de lenguaje inmensos, que son capaces de aprender a realizar tareas con tan solo dos o tres ejemplos. Esta capacidad, junto a la facilidad por interpretar las órdenes, ha facilitado la creación LEER MÁS

QLoRA: entrenar un Gran Modelo de Lenguaje en una GPU de 16 GB.

Si juntamos las dos técnicas podemos cargar un gran modelo de lenguaje en mucha menos memoria de la que necesitaría y fine-tunearlo. Combinando las dos somos capaces de fine-tunear modelos de 7B, como Lllama-2 7B, o Bloom 7B en una GPU que tan solo disponga de 16 GB de memoria. Con lo que nos encontramos LEER MÁS

Fine-Tuning eficiente con LoRA. Entrena de forma óptima los Grandes Modelos de Lenguaje.

LoRA es una de las técnicas más eficientes y efectivas de Fine-Tuning aplicable a Grandes Modelos de Lenguaje que existe actualmente. Es una técnica de reparametrizacion, actualizando el peso de parámetros específicos y no de todos los del modelo. Las dos ventajas más claras al usar LoRA son: La forma utilizada para reducir el número LEER MÁS

Prompt Tuning de Modelos con la Librería PEFT de Hugging Face.

Si estás leyendo esto, es que realmente estás interesado en nuevas técnicas de Fine-Tuning de Grandes Modelos de Lenguaje. He sido totalmente incapaz de crear un título que sea medio entendible, y mucho menos atractivo, para alguien que no sepa lo que es el Fine-Tuning. Vamos a ver si como mínimo consigo explicar lo que LEER MÁS

Introducción al FineTuning con Soft Prompting y LoRA de la librería PEFT de Hugging Face.

Realizar un entreno desde 0 de uno de los Grandes Modelos de Lenguaje actuales es una acción al alcance de muy poco. Las horas de GPUs necesarias y el coste son prohibitivos para la mayoría de las empresas, y no estoy hablando de pequeñas empresas. Empresas que se pueden considerar grandes, sobre todo a nivel LEER MÁS

Creación de un sistema automoderado de comentarios con LLAMA-2 y LangChain.

En este artículo veremos como crear un sistema que sea capaz de responder a los comentarios de los usuarios de un supuesto foro de opinión o soporte de una empresa. En este artículo vamos a basar la solución en separar el modelo responsable de publicar la respuesta de la entrada del usuario. Es decir, el LEER MÁS

Creación de un sistema de comentarios con LangChain y OpenAI.

Como disclaimer me gustaría indicar que este artículo es tan solo un ejemplo creado para ver como funciona la herramienta LangChain. Hay muchas formas diferentes de crear un sistema automoderado de comentarios, la que veremos en este artículo es una solución muy simple. La idea básica es aislar al Modelo que acaba publicando la respuesta, LEER MÁS